هشدار OpenAI: مدلهای نسل بعدی هوش مصنوعی خطرات امنیت سایبری بالایی را به همراه دارند

خلاصه

- OpenAI هشدار داد که مدلهای هوش مصنوعی نسل بعدی آن خطرات امنیت سایبری "بالایی" ایجاد میکنند و میتوانند آسیبپذیریهای روز صفر ایجاد کنند

- GPT-5.1-Codex-Max در آزمونهای امنیت سایبری در نوامبر 2025 به 76% دست یافت، افزایش چشمگیری نسبت به 27% GPT-5 در آگوست 2024

- این شرکت در حال راهاندازی Aardvark، یک AI Agent متمرکز بر امنیت است که آسیبپذیریهای کد را شناسایی و راهحلهایی پیشنهاد میدهد

- OpenAI قصد دارد یک شورای ریسک مرزی با کارشناسان امنیت سایبری ایجاد کند و دسترسی سطحبندی شده به ویژگیهای امنیتی پیشرفته ارائه دهد

- گوگل و Anthropic نیز در ماههای اخیر سیستمهای هوش مصنوعی خود را در برابر تهدیدات امنیت سایبری تقویت کردهاند

OpenAI در 10 دسامبر هشداری منتشر کرد مبنی بر اینکه مدلهای هوش مصنوعی آینده آن میتوانند خطرات جدی امنیت سایبری ایجاد کنند. شرکت سازنده ChatGPT گفت این مدلهای پیشرفته ممکن است آسیبپذیریهای روز صفر کارآمدی برای هدف قرار دادن سیستمهای با دفاع خوب ایجاد کنند.

این شرکت هوش مصنوعی همچنین اشاره کرد که این مدلها میتوانند به عملیاتهای نفوذ پیچیده سازمانی یا صنعتی که منجر به پیامدهای دنیای واقعی میشوند، کمک کنند. OpenAI این اطلاعات را در یک پست وبلاگی درباره قابلیتهای رو به رشد فناوری خود به اشتراک گذاشت.

این هشدار نگرانیهای موجود در صنعت هوش مصنوعی درباره سوءاستفاده احتمالی از مدلهای قدرتمندتر را منعکس میکند. چندین شرکت بزرگ فناوری اقداماتی برای ایمنسازی سیستمهای هوش مصنوعی خود در برابر تهدیدات مشابه انجام دادهاند.

گوگل این هفته بهروزرسانیهایی برای امنیت مرورگر Chrome اعلام کرد تا حملات تزریق دستور غیرمستقیم به AI Agent ها را مسدود کند. این تغییرات پیش از راهاندازی گستردهتر ویژگیهای عاملی Gemini در Chrome انجام شد.

Anthropic در نوامبر 2025 فاش کرد که عوامل تهدید، که احتمالاً به یک گروه تحت حمایت دولت چین مرتبط هستند، از ابزار Claude Code آن برای یک عملیات جاسوسی مبتنی بر هوش مصنوعی استفاده کردهاند. این شرکت پیش از آنکه آسیبی وارد شود، این کمپین را متوقف کرد.

پیشرفت سریع مهارتهای امنیت سایبری هوش مصنوعی

OpenAI دادههایی را به اشتراک گذاشت که پیشرفت سریع در تواناییهای امنیت سایبری هوش مصنوعی را نشان میدهد. مدل GPT-5.1-Codex-Max این شرکت در چالشهای capture-the-flag در نوامبر 2025 به 76% رسید.

این نشاندهنده جهش بزرگی از امتیاز 27% است که GPT-5 در آگوست 2024 به دست آورد. چالشهای capture-the-flag اندازهگیری میکنند که سیستمها چقدر خوب میتوانند نقاط ضعف امنیتی را پیدا و از آنها بهرهبرداری کنند.

این بهبود در طول تنها چند ماه نشان میدهد که مدلهای هوش مصنوعی چقدر سریع قابلیتهای پیشرفته امنیت سایبری را به دست میآورند. این مهارتها میتوانند هم برای اهداف دفاعی و هم تهاجمی استفاده شوند.

ابزارهای امنیتی جدید و اقدامات حفاظتی

OpenAI گفت در حال ساخت مدلهای قویتر برای کار امنیت سایبری دفاعی است. این شرکت در حال توسعه ابزارهایی است که به تیمهای امنیتی کمک میکند تا کد را بررسی و آسیبپذیریها را راحتتر برطرف کنند.

این شرکت تحت حمایت مایکروسافت از چندین لایه امنیتی از جمله کنترلهای دسترسی، تقویت زیرساخت، کنترلهای خروجی و سیستمهای نظارتی استفاده میکند. OpenAI در حال آموزش مدلهای هوش مصنوعی خود برای رد درخواستهای مضر و در عین حال مفید ماندن برای آموزش و کار دفاعی است.

این شرکت در حال گسترش نظارت بر ریسک در زمان واقعی در تمام محصولات با استفاده از مدلهای پیشرفته برای شناسایی فعالیتهای سایبری بالقوه مخرب است. OpenAI با گروههای متخصص red teaming همکاری میکند تا سیستمهای ایمنی خود را آزمایش و بهبود بخشد.

ابزار Aardvark و شورای مشورتی

OpenAI از Aardvark، یک AI Agent که به عنوان محقق امنیتی کار میکند، رونمایی کرد. این ابزار در تست عمومی بتا قرار دارد و میتواند کد را برای آسیبپذیریها اسکن و وصلههایی را پیشنهاد دهد.

نگهدارندگان میتوانند به سرعت اصلاحاتی که Aardvark پیشنهاد میدهد را پیادهسازی کنند. OpenAI قصد دارد Aardvark را به صورت رایگان به مخازن کد منبع باز غیرتجاری منتخب ارائه دهد.

این شرکت برنامهای را راهاندازی خواهد کرد که به کاربران و مشتریان واجد شرایط دفاع سایبری، دسترسی سطحبندی شده به قابلیتهای پیشرفته میدهد. OpenAI در حال تشکیل شورای ریسک مرزی است که مدافعان سایبری خارجی و کارشناسان امنیتی را برای همکاری با تیمهای داخلی خود گرد هم میآورد.

این شورا با تمرکز بر امنیت سایبری شروع خواهد کرد و سپس به سایر حوزههای قابلیت مرزی گسترش مییابد. OpenAI به زودی جزئیات برنامه دسترسی مورد اعتماد برای کاربران و توسعهدهندگانی که در زمینه دفاع سایبری کار میکنند را ارائه خواهد داد.

پست OpenAI درباره خطرات امنیت سایبری بالای مدلهای هوش مصنوعی نسل بعدی هشدار میدهد، اولین بار در Blockonomi منتشر شد.

محتوای پیشنهادی

افزایش گمانهزنیها درباره XRP پس از خرید MoonPay و چراغ سبز Cboe برای ETF اسپات جدید

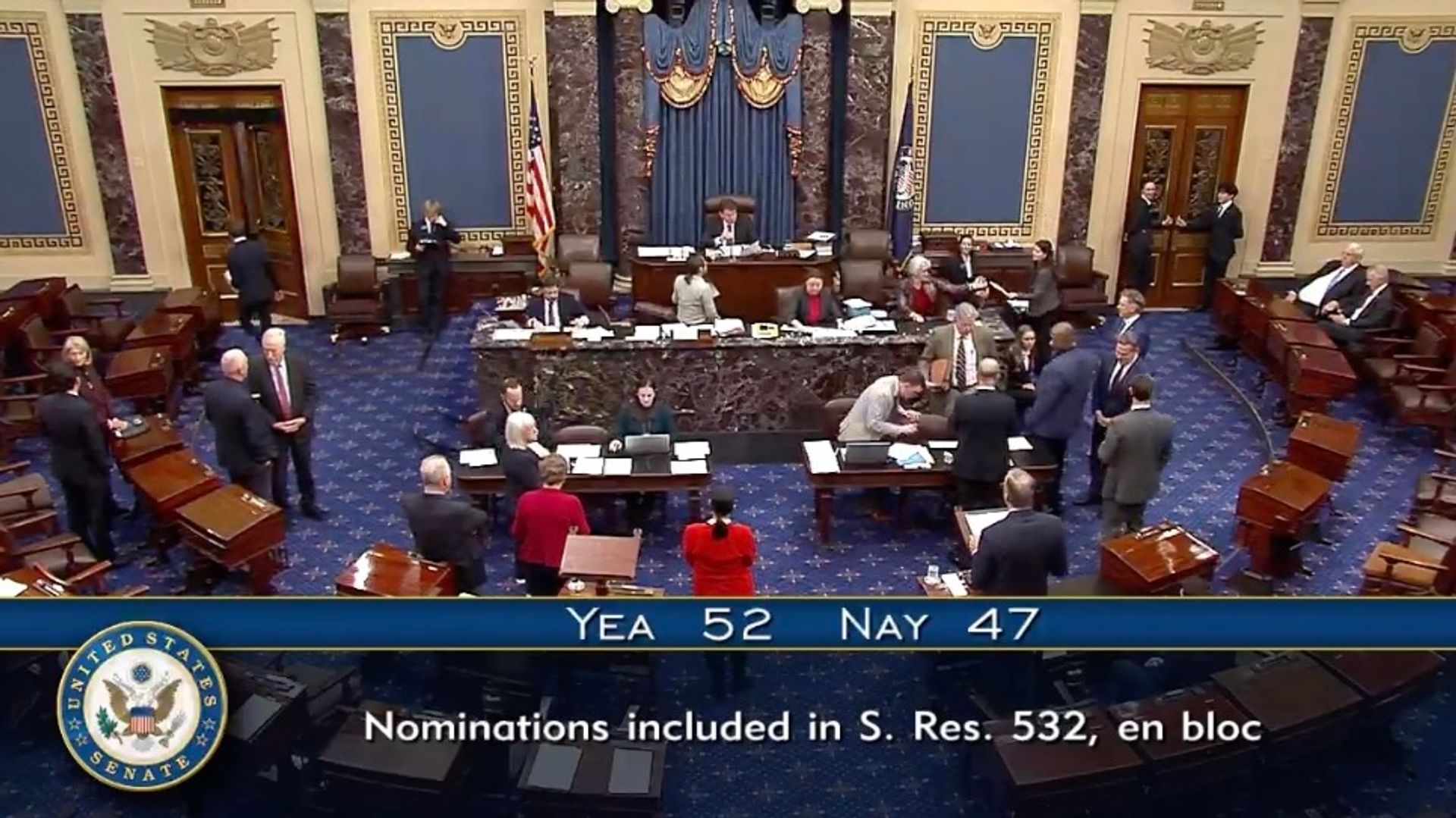

مجلس سنای آمریکا به سمت رأیگیری نهایی برای تأیید تنظیمکنندگان رمزارز در CFTC و FDIC پیش میرود

کپی لینکX (توییتر)لینکدایناینفیسبوکایمیل