Grok : X va limiter la modification d'images de personnes réelles par les utilisateurs après un tollé international

La société d'IA d'Elon Musk, xAI, a introduit des mesures visant à renforcer les contrôles sur sa fonctionnalité de génération d'images Grok. Cette décision intervient après une inquiétude croissante concernant la manière dont les utilisateurs sur la plateforme X modifiaient des photos de personnes réelles.

Les régulateurs, les groupes de défense des droits et les médias ont tiré la sonnette d'alarme concernant l'utilisation abusive de l'outil pour générer de la pornographie deepfake non consensuelle. La réaction a été unanime de l'Amérique à l'Europe et à travers l'Afrique.

Des rapports d'autorités et de journalistes montrant que Grok était utilisé pour générer du contenu explicite sans consentement ont incité xAI à agir.

Selon l'équipe de sécurité de l'entreprise, de nouvelles mesures de protection empêchent désormais tous les utilisateurs de modifier des images de personnes réelles en vêtements révélateurs tels que des bikinis ou des sous-vêtements dans les juridictions où ce contenu enfreint la loi locale. Cette mesure s'applique à tous, y compris aux abonnés premium.

Deepfake

Deepfake

Ce changement marque un tournant significatif pour Grok. Des plaintes antérieures avaient décrit comment les utilisateurs pouvaient demander à l'IA de "déshabiller" ou de modifier des photos pour créer des images deepfake de femmes et de mineurs. Des enquêtes en Californie indiquent que plus de la moitié des dizaines de milliers d'images générées pendant une période de vacances récente montraient des personnes en vêtements minimaux, certaines semblant être mineures. Cet examen juridique a renforcé les critiques.

Les fonctionnalités d'image de Grok de xAI, désormais strictement contrôlées

Dans une publication sur son compte officiel de sécurité, X a déclaré que bien que les fonctionnalités d'image de Grok soient désormais strictement contrôlées, elles n'ont pas été entièrement supprimées. La création et la modification d'images via Grok resteront disponibles, mais uniquement pour les abonnés payants sur la plateforme X.

L'entreprise a déclaré que cela améliorerait la responsabilité et aiderait à tracer les abus. Le géoblocage a également été introduit dans les pays où de telles créations sont illégales, empêchant efficacement les utilisateurs de ces régions de générer du contenu problématique.

Les contrôles renforcés n'ont pas fait taire les critiques. Certains régulateurs et organismes de surveillance ont déclaré que les mesures restaient insuffisantes.

Des rapports médiatiques et des tests d'investigation suggèrent que les protections peuvent être contournées dans certains cas. Les critiques soutiennent que mettre des capacités nuisibles derrière un paywall n'empêche pas leur existence mais les empile plutôt derrière un mur d'abonnement. D'autres notent que l'application autonome Grok et le portail web permettent toujours certaines manipulations d'images sans les mêmes restrictions.

Il y a également une pression internationale croissante. Des responsables gouvernementaux en Californie, dans l'Union européenne et dans plusieurs pays asiatiques ont tous exprimé leurs préoccupations concernant l'utilisation abusive des deepfakes.

Certains régulateurs envisagent ou poursuivent désormais des actions en justice contre xAI et X pour ne pas en faire assez pour empêcher la création d'images prédatrices ou exploitantes sur leur plateforme. En réponse, la Commission européenne a déclaré qu'elle évaluerait les nouvelles mesures de protection pour s'assurer qu'elles protègent véritablement les citoyens.

Cet épisode intervient dans le cadre d'un débat plus large sur la manière de gouverner l'IA générative de manière responsable. Notre analyse récente a souligné que la conception "non filtrée" de Grok le rendait particulièrement vulnérable aux abus, le transformant en outil de pornographie deepfake non consensuelle à grande échelle. Cet article explorait comment la combinaison de protections laxistes et de modèles génératifs puissants peut rapidement devenir une crise sociale et juridique si elle n'est pas traitée.

Pour l'instant, xAI maintient qu'elle ajuste Grok en réponse aux risques émergents. L'entreprise a présenté les derniers contrôles comme faisant partie des efforts continus pour travailler avec les utilisateurs, les régulateurs et les partenaires sur la sécurité.

Mais le défi plus large demeure : comment équilibrer l'innovation en IA générative avec des protections robustes pour la vie privée, la dignité et les droits des individus. Les régulateurs et les groupes de défense affirment que ce n'est que le début d'un parcours juridique et éthique complexe.

L'article Grok : X limite la façon dont les utilisateurs modifient les images de personnes réelles après une réaction internationale est apparu en premier sur Technext.

Vous aimerez peut-être aussi

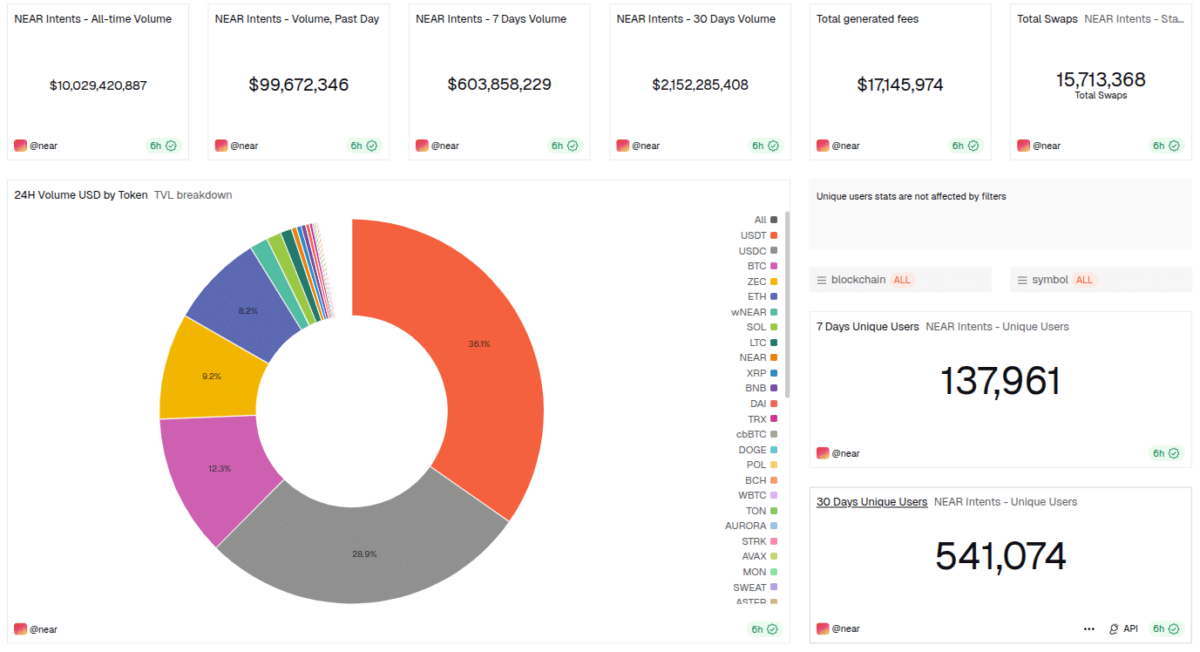

NEAR Intents atteint 10 milliards $ de volume d'échange alors que le soutien de l'industrie et l'adoption augmentent

Le Volume Social de Monero atteint un record historique – XMR bondit au-dessus de 796 $ dans un boom des cryptos de confidentialité et une pression réglementaire