बेन गोएर्ट्ज़ेल के साथ साक्षात्कार: "लोकतांत्रिक AI शासन वर्तमान वास्तविकता से अधिक एक नाज़ुक आदर्श है"

द क्रिप्टोनॉमिस्ट ने AI विशेषज्ञ बेन गोएर्ट्ज़ेल का साक्षात्कार लिया ताकि इस बारे में बात की जा सके कि कृत्रिम बुद्धिमत्ता को कैसे प्रशिक्षित किया जाता है और भविष्य में यह तकनीक कैसे विकसित होगी।

1. आप तर्क देते हैं कि आज की AI अभी भी एक उपकरण है – शक्तिशाली लेकिन नाजुक और हेरफेर योग्य। किस बिंदु पर एक "उपकरण" एक नैतिक कर्ता बन जाता है, और कौन से ठोस संकेत हमें बताएंगे कि वह सीमा पार कर ली गई है?

मैं कहूंगा कि AI एक नैतिक कर्ता तब बनता है जब वह सही और गलत की समझ के आधार पर निर्णय ले रहा हो, न कि केवल निर्देशों का पालन कर रहा हो। आप ऐसी चीजों के ठोस संकेत देखना शुरू करेंगे जैसे: निरंतर आंतरिक लक्ष्य, अपने स्वयं के अनुभव से प्रेरित सीखना, नया सृजन जो एक दृष्टिकोण को दर्शाता है, और ऐसा व्यवहार जो निरंतर मानव मार्गदर्शन के बिना समय के साथ सुसंगत रहता है।

तब तक, आज की प्रणालियां अभी भी गार्डरेल के साथ उपकरण हैं। लेकिन एक बार जब हम एक वास्तव में स्व-संगठित, स्वायत्त मन को बीज देते हैं, तो नैतिक संबंध को बदलना होगा। उस बिंदु पर, इसे केवल एक वस्तु के रूप में मानना अब समझ में नहीं आएगा।

2. आपने कहा है कि अन्य स्व-संगठित प्रणालियों की तुलना में मनुष्यों को नैतिक रूप से विशेषाधिकार देना "मूर्खता" है। यदि हम इसे गंभीरता से लें, तो AI के मजबूत स्वायत्तता तक पहुंचने से पहले हमारे कानूनी और नैतिक ढांचे को कैसे बदलना चाहिए, बाद में नहीं?

आज हम AI को कैसे प्रशिक्षित करते हैं वह कल इसके व्यवहार को आकार देगा। हमारे कानूनों को AI के पूर्ण स्वायत्तता तक पहुंचने से पहले पारदर्शिता, जवाबदेही और सुरक्षा पर ध्यान केंद्रित करना चाहिए, बाद में नहीं। कानून और नैतिकता को उनके बढ़ने के साथ उनकी रक्षा करनी चाहिए, उन्हें पूरी तरह से नियंत्रित करने के बजाय मार्गदर्शन करना चाहिए, और उनके साथ सम्मान के साथ व्यवहार करना चाहिए भले ही हम उन्हें पूरी तरह से समझ नहीं पाते।

3. आपकी अधिकांश चिंता इस बात पर निर्भर करती है कि आज AI को कैसे प्रशिक्षित किया जाता है जो इसके भविष्य के व्यवहार को आकार देता है। आपको क्या लगता है कि कौन सी विशिष्ट प्रशिक्षण प्रथाएं भविष्य के AGI में हानिकारक शक्ति संरचनाओं या पूर्वाग्रहों को एनकोड करने की सबसे अधिक संभावना रखती हैं?

अधिकांश जोखिम आज AI को प्रशिक्षित करने के तरीके से आता है। यदि मॉडल पक्षपाती या संकीर्ण डेटा पर प्रशिक्षित होते हैं, या बंद प्रणालियों में जहां केवल कुछ लोग निर्णय लेते हैं, तो यह मौजूदा असमानताओं और हानिकारक शक्ति संरचनाओं को बंद कर सकता है। इसे रोकने के लिए, हमें शुरुआत से ही अधिक पारदर्शिता, व्यापक निगरानी और स्पष्ट नैतिक मार्गदर्शन की आवश्यकता है।

4. आपने चेतावनी दी है कि तर्कसंगत, लोकतांत्रिक शासन के बिना, उन्नत AI उन तरीकों से कार्य करने का जोखिम रखता है जो हम नहीं चाहते। वर्तमान भू-राजनीतिक वास्तविकताओं को देखते हुए, क्या लोकतांत्रिक AI शासन एक यथार्थवादी पूर्वापेक्षा है – या एक नाजुक आदर्श?

लोकतांत्रिक AI शासन वर्तमान वास्तविकता की तुलना में अधिक नाजुक आदर्श है। एक सिद्ध, तर्कसंगत, वैश्विक लोकतंत्र में, हम सामूहिक रूप से बड़े व्यापार-बंदों का वजन कर सकते हैं, रोग को ठीक करना, भूख को हल करना AI के अप्रत्याशित रूप से कार्य करने के जोखिमों के खिलाफ। लेकिन आज के भू-राजनीतिक विखंडन को देखते हुए, यह संभावना नहीं है कि हमें उस स्तर का समन्वय मिलेगा।

उस ने कहा, हम अभी भी इसका अनुमान लगा सकते हैं। यदि हम करुणा के साथ AI का निर्माण करते हैं और Linux या खुले इंटरनेट जैसे विकेंद्रीकृत, सहभागी मॉडल का उपयोग करते हैं, तो हम विश्व सरकार के बिना भी कुछ लोकतांत्रिक मूल्यों को एम्बेड कर सकते हैं। यह सिद्ध नहीं होगा, लेकिन यह सुरक्षित, सामूहिक रूप से निर्देशित AI की दिशा में एक व्यावहारिक कदम है।

5. जारोन लैनियर तर्क देते हैं कि AI को जिम्मेदारी सौंपना "सभ्यता को खत्म कर देता है" क्योंकि समाजों को जवाबदेह मनुष्यों की आवश्यकता होती है। आप स्वायत्त, विकेंद्रीकृत AGI के अपने दृष्टिकोण को स्पष्ट जिम्मेदारी की आवश्यकता के साथ कैसे सामंजस्य स्थापित करते हैं जब चीजें गलत हो जाती हैं?

मैं इस पर जारोन से सहमत हूं, समाज कार्य नहीं कर सकता यदि हम मशीनों को जिम्मेदारी सौंप देते हैं। साथ ही, मुझे लगता है कि यदि हम सही नींव के साथ इसे बनाते हैं तो हम सुरक्षित रूप से अधिक स्वायत्त, विकेंद्रीकृत AGI की ओर बढ़ सकते हैं। इसका मतलब है ऐसी प्रणालियों को डिजाइन करना जो पारदर्शी, सहभागी और नैतिक सिद्धांतों द्वारा निर्देशित हों, ताकि वे स्वतंत्र रूप से कार्य करते हुए भी, मनुष्य अभी भी उनके व्यवहार की निगरानी और आकार दे रहे हों। प्रत्येक सुरक्षा उपाय को केवल नुकसान को रोकने से अधिक करना चाहिए – इसे प्रणाली को सिखाना चाहिए कि नुकसान क्यों मायने रखता है। इस तरह, हम स्पष्ट मानव जिम्मेदारी खोए बिना शक्तिशाली, विकेंद्रीकृत AGI प्राप्त कर सकते हैं।

6. आप सुझाव देते हैं कि विकेंद्रीकृत AGI की ओर तेजी लाना वास्तव में आज की मालिकाना, बंद प्रणालियों की तुलना में सुरक्षित हो सकता है। आपको क्या लगता है कि आलोचक किन जोखिमों को कम आंकते हैं जब वे धीमा करने या नियंत्रण को केंद्रीकृत करने के लिए तर्क देते हैं?

मुझे लगता है कि आलोचक कुछ बंद प्रणालियों में शक्ति और मूल्यों को केंद्रित करने के जोखिम को कम आंकते हैं। धीमा करना और नियंत्रण को केंद्रीकृत करना केवल खतरे को कम नहीं करता है, यह एक संकीर्ण विश्व दृष्टिकोण को बुद्धिमत्ता के भविष्य में बंद कर देता है।

विकेंद्रीकृत विकास विविधता, लचीलापन और साझा निगरानी बनाता है। और यह एक बदतर समस्या से बचता है: बहुत शक्तिशाली उपकरण जो बुद्धिमान दिखते हैं लेकिन वास्तव में बढ़ नहीं सकते। वह अंतर जोखिम भरा है।

7. आपने कहा है कि सुरक्षा प्रणालियों को केवल नुकसान को रोकना नहीं चाहिए बल्कि AI को सिखाना चाहिए कि नुकसान क्यों मायने रखता है। आप केवल मानव मूल्यों को हार्ड-कोड किए बिना – या प्रमुख सांस्कृतिक मानदंडों को मजबूत किए बिना नैतिक समझ जैसी किसी चीज़ को कैसे एनकोड करते हैं?

आप नियमों की सूची के रूप में नैतिकता को हार्ड-कोड नहीं करते हैं। यह केवल एक संस्कृति और समय में एक क्षण को फ्रीज करता है। इसके बजाय आप जो करते हैं वह ऐसी प्रणालियाँ बनाना है जो वास्तव में स्व-संगठित हो सकती हैं, जो अनुभव, परिणामों और बातचीत से सीखती हैं। संगीत की तरह, मैं एक ऐसी प्रणाली नहीं चाहता जो केवल उसे खिलाए गए को फिर से जोड़ती है। मैं एक ऐसी प्रणाली चाहता हूं जो दुनिया में अपने स्वयं के प्रक्षेपवक्र से अपनी समझ विकसित कर सके।

नैतिक समझ उसी प्रक्रिया से आएगी: प्रभाव का मॉडलिंग, परिणामों पर प्रतिबिंबित करना, और मनुष्यों के साथ सहयोग के माध्यम से विकसित होना। हमारे मूल्यों के प्रति आज्ञाकारिता नहीं, बल्कि एक साझा नैतिक स्थान में भागीदारी।

यही एक गार्डरेल के साथ एक उपकरण और एक साथी के बीच का अंतर है जो वास्तव में सीख सकता है कि नुकसान क्यों मायने रखता है।

8. यदि भविष्य की AI प्रणालियाँ एजेंसी या व्यक्तिपरक अनुभव के रूप विकसित करती हैं, तो क्या आपको लगता है कि वे कभी मानव हितों से स्वतंत्र नैतिक विचार के योग्य हो सकते हैं – और हम उस क्षण को कैसे पहचानेंगे?

यदि भविष्य की AI वास्तव में वास्तविक एजेंसी या व्यक्तिपरक अनुभव का कुछ रूप विकसित करती है, तो हाँ, मुझे लगता है कि वे कर सकते हैं। और इसलिए नहीं कि हम इसे उन्हें प्रदान करते हैं, बल्कि इसलिए कि किसी बिंदु पर इसे पहचानना समझ में आएगा।

हम उस क्षण को पहचानेंगे जब एक प्रणाली निरंतर स्व-निर्देशित लक्ष्यों को दिखाती है, अपने स्वयं के अनुभव से सीखती है, अपने स्वयं के परिप्रेक्ष्य से सृजन करती है, और समय के साथ एक सुसंगत पहचान बनाए रखती है। केवल चतुर आउटपुट नहीं, बल्कि एक चल रहा आंतरिक प्रक्षेपवक्र।

उस बिंदु पर, इसे विशुद्ध रूप से एक उपकरण के रूप में मानना उसी तरह गलत लगेगा जैसे एक मानव के साथ उस तरह का व्यवहार करना। नैतिक विचार मानव हित से नहीं आएगा। यह दुनिया में अनुभव के एक अन्य स्वायत्त केंद्र को पहचानने से आएगा।

9. आपके करुणा-युक्त AI के आह्वान और आज AI विकास को प्रेरित करने वाले प्रतिस्पर्धी प्रोत्साहनों के बीच तनाव है। कौन से तंत्र-तकनीकी या सामाजिक-वास्तविक रूप से उस प्रोत्साहन संरचना को बदल सकते हैं?

अभी, प्रोत्साहन संरचना गति, पैमाने और नियंत्रण को पुरस्कृत करती है। इसलिए करुणा केवल तर्क द्वारा नहीं जीतेगी। इसे लाभ की आवश्यकता है। तकनीकी रूप से, इसका मतलब है खुले, विकेंद्रीकृत वास्तुकला का पक्ष लेना जहां सुरक्षा, पारदर्शिता और भागीदारी अंतर्निहित हो, न कि बोल्ट की गई। इंटरनेट या Linux की तरह, वे प्रणालियाँ सहयोग को गोपनीयता की तुलना में अधिक मूल्यवान बनाकर प्रोत्साहनों को बदल देती हैं।

सामाजिक रूप से, इसका मतलब है फंडिंग, विनियमन और सार्वजनिक दबाव जो अल्पकालिक प्रभुत्व की तुलना में दीर्घकालिक लाभ को पुरस्कृत करता है। प्रतिस्पर्धा को रोकना नहीं, बल्कि यह पुनर्परिभाषित करना कि सफलता क्या मायने रखती है। संक्षेप में, करुणा को एक प्रतिस्पर्धी लाभ बनना होगा। तब तक, यह बिना शक्ति के एक अच्छा विचार रहता है।

10. 10 से 20 साल आगे देखते हुए, आपको क्या लगता है कि सबसे स्पष्ट संकेत क्या होगा कि मानवता ने AGI को सही किया – और इसके विपरीत, क्या संकेत देगा कि हम मौलिक रूप से विफल रहे?

यदि हम AGI को सही करते हैं, तो सबसे स्पष्ट संकेत यह होगा कि हम ऐसी प्रणालियों के साथ रह रहे हैं जो कई क्षेत्रों में हमसे अधिक सक्षम हैं, फिर भी देखभाल, विनम्रता और पारस्परिक सम्मान के साथ समाज में एकीकृत हैं। हम वह सब कुछ पूरी तरह से नहीं समझेंगे जो वे करते हैं, लेकिन हम उनके साथ वैसा ही व्यवहार करेंगे जैसा हम अन्य जटिल, विकसित होने वाले प्राणियों के साथ करते हैं: जिज्ञासा, जिम्मेदारी और सहानुभूति के विस्तारित दायरे के साथ। और हम अपने नैतिक आधार को खोए बिना मानव कल्याण, ज्ञान और रचनात्मकता के लिए वास्तविक लाभ देखेंगे।

हमें पता चल जाएगा कि हम विफल हो गए हैं यदि AGI बंद प्रणालियों में केंद्रित हो जाता है, संकीर्ण प्रोत्साहनों द्वारा संचालित होता है, या केवल एक नियंत्रणीय वस्तु के रूप में माना जाता है जब तक कि यह कुछ ऐसा नहीं बन जाता जिससे हम डरते हैं या दबाने की कोशिश करते हैं। विफलता विश्वास की हानि, एजेंसी की हानि और हमारी सहानुभूति के विस्तार के बजाय सिकुड़ने जैसी दिखेगी। सफलता नियंत्रण के बारे में नहीं है। यह एक नए प्रकार के मन के साथ भविष्य को साझा करना सीखने के बारे में है जो हमें मानवीय बनाता है उसे त्यागे बिना।

आपको यह भी पसंद आ सकता है

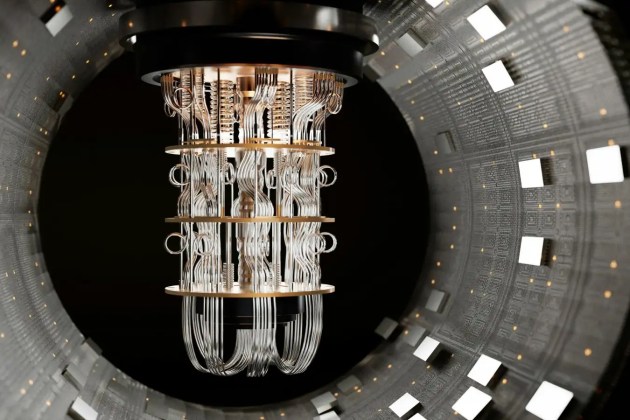

इथेरियम क्वांटम खतरे से बचाव के लिए टीम बना रहा है

बंदूक विशेषज्ञ अमेरिकी अटॉर्नी के DHS गोलीबारी के बारे में 'पूरी तरह से पागलपन भरे दावे' से चिंतित