Is Shadow AI erger dan Shadow IT?

Een rustig kantoor kan onschuldig lijken. Rekken met monitoren gebaad in licht, koptelefoons die gesprekken bedekken, en de drukte van werk gaat door zonder enig teken dat er iets kwaadaardigs onder ligt. Maar steeds vaker zijn er onbedoelde, niet-goedgekeurde technologieën — hier een persoonlijke cloudmap en daar een niet-goedgekeurde AI-chatbot. Binnenkort zal de organisatie al deze nieuwe onvoorziene risico's moeten beheren. Maar shadow IT was slechts de eerste lading verborgen bedreigingen. Shadow AI heeft de inzet verhoogd.

Wat Shadow AI is en waarom het groeit

Als uitbreiding van shadow IT, omvat shadow AI werknemers die niet-goedgekeurde technologie gebruiken. Shadow IT verwijst doorgaans naar consumententechnologie, zoals bestandsdelingsapps of persoonlijke apparaten. Shadow AI betreft meestal snelbewegende, datahongerige systemen waarvan het gedrag onvoorspelbaar kan zijn.

\ Volgens onderzoek uitgevoerd door Gartner ervaart 80% van de organisaties hiaten in datagovernance. Deze hiaten maken het gemakkelijker voor mensen om door AI gegenereerd gedrag te missen. Veel teams falen bij cyberbeveiligingsbeoordelingen. Het risico geassocieerd met AI wordt vergroot doordat werknemers nieuwe tools sneller adopteren dan hun teams ze adequaat kunnen beoordelen. Aangezien 30% van de datalekken afkomstig is van leveranciers of toeleveranciers, is het kennen van de tools die een team gebruikt een kritisch onderdeel van het beveiligen van de digitale middelen van een bedrijf.

\ Shadow AI heeft aan populariteit gewonnen omdat werknemers door AI gegenereerde content zien als een snellere manier om content te creëren, complexe informatie samen te vatten en technische problemen op te lossen. Het vermindert wrijving in het dagelijkse werk maar introduceert risico's die niet eerder werden gezien bij shadow IT-zorgen, waaronder blootstelling van gegevens, nalevingsrisico's en risico's op modelniveau.

Shadow AI versus Shadow IT

Shadow IT wordt al lang beschuldigd van onbekende kwetsbaarheden. Een hoog percentage van eerdere inbreuken was te wijten aan niet-ondertekende SaaS-tools of persoonlijke opslag. AI-tools veranderen de vergelijking volledig. De schaal en snelheid waarmee ze werken, samen met hun ondoorzichtigheid, creëren risico's die moeilijker te detecteren en te beheersen zijn.

\ Met 78% van de organisaties die AI in productie gebruiken, zijn sommige inbreuken nu te wijten aan onbeheerde technologieblootstelling. Het grotere IT-model is nog steeds belangrijk, maar AI introduceert een nieuwe dimensie om het aanvalsoppervlak te verbreden.

Belangrijkste verschillen tussen Shadow AI en Shadow IT

Shadow AI lijkt op shadow IT in die zin dat beide voortkomen uit de wens van een werknemer om productiever te zijn, maar ze verschillen in waar het risico ligt.

- Shadow IT-tools hebben vaste logica, wat gedrag voorspelbaar maakt. Het voorspellen van het gedrag van shadow AI-tools is complexer omdat modellen continu kunnen worden gewijzigd en opnieuw getraind.

- Shadow IT-risico's omvatten gegevens die zonder toestemming worden opgeslagen of verplaatst. Shadow AI-risico's omvatten modelinversie, datavergiftiging en modeltraining.

- Shadow IT is deterministisch, terwijl AI-tools kunnen hallucineren, slecht generaliseren en overmoedig onjuiste outputs produceren.

\ Shadow AI ontstaat ook in de context van aankomende regelgeving, zoals de EU Artificial Intelligence Act, die het toezicht door regelgevers zou kunnen vergroten.

Beveiligingsrisico's die Shadow AI urgenter maken

Shadow AI kan leiden tot problemen in engineering, marketing en financiën. Naarmate beslissingen worden genomen op basis van AI-outputs, kunnen bedrijfseigen gegevens lekken en kunnen interne bedrijfsprocessen worden gemanipuleerd zonder dat iemand het opmerkt.

\

- Modelmanipulatie: Aanvallers kunnen gegevens maken die resultaten vertekenen.

- Blootstelling aan prompt-injectie: Een gecreëerde prompt kan worden gebruikt om privé-informatie uit een model te halen.

- Hiaten in gegevensafstamming: AI-tools kunnen gegevens genereren en opslaan op manieren die beveiligingsteams niet kunnen volgen.

- Compliance-drift: AI-tools veranderen, en evoluerende governanceplannen kunnen irrelevant worden.

\ De bezorgdheid groeit met de komst van generatieve AI. Een chatbot die een vraag van een leverancier beantwoordt of een generatieve AI-samenvatting kan onschadelijk lijken, maar riskeert het onthullen van gevoelige gebruiksgegevens of waardevolle bedrijfseigen intellectuele eigendom. Carnegie Mellon University ontdekte dat grote taalmodellen veel kwetsbaarder zijn voor vijandige prompts dan op regels gebaseerde systemen. Het probleem neemt toe wanneer werknemers de tools zonder toezicht kunnen gebruiken.

\ Een door AI mogelijk gemaakte beslisboom kan meer bevooroordeeld zijn dan een conventionele beslisboom. Shadow AI ontvangt vaak onvolledige trainingsinformatie die in tools van derden wordt ingevoerd. Gestructureerd toezicht op AI-systemen zou de integriteit van updates waarborgen. Wanneer teams dit over het hoofd zien, driften de gegevens en het gedrag van het model.

Hoe beveiligingsteams Shadow AI-blootstelling kunnen verminderen

Hoewel shadow AI talrijke risico's met zich meebrengt, kunnen organisaties veel ervan beperken door zichtbaarheid te combineren met beleid en technische controles, waarbij een balans wordt gevonden die de productiviteit van werknemers beschermt zonder hen te belasten met tijdrovende check-ins of geblokkeerde sites. Beveiligingsteams hebben baat bij het behandelen van shadow AI als een governance-kwestie in plaats van een strafkwestie. Mitigatiestrategieën zullen onvermijdelijk moeten evolueren naarmate werknemers AI-tools gebruiken om de productiviteit te verbeteren.

1. Bouw een duidelijk AI-governance-framework

Een governanceplan moet specificeren welke AI-tools moeten worden goedgekeurd, welke soorten gegevens werknemers kunnen gebruiken, hoe modeloutputs moeten worden beoordeeld voordat er beslissingen met hoge inzet worden genomen, en wat te doen wanneer er onvoorspelbaar modelgedrag optreedt. Het laatste element omvat wie het gedrag beoordeelt, wie de oorzaken onderzoekt en wat de gevolgen zijn.

\ Met toezicht op zijn plaats kunnen organisaties AI behandelen als elk ander bedrijfsmiddel, onderworpen aan dezelfde traceerbaarheid, controleerbaarheid, beveiliging en nalevingsverantwoordelijkheden als andere legacy-bedrijfssystemen.

2. Bied goedgekeurde AI-tools aan

Teams met toegang tot gecontroleerde, gecentraliseerde AI-tools zijn minder geneigd om zich te wenden tot niet-goedgekeurde openbare AI's om blokkades te omzeilen. Naarmate banen meer geautomatiseerd worden, zullen medewerkers meer moeite steken in verschillende modellen. Werknemers besteden al ongeveer 4,6 uur per week aan het gebruik van AI op het werk, wat meer is dan de gemiddelde persoonlijke gebruikstijd van 3,6 uur per week. AI van derden, zonder goede monitoring, is mogelijk al gebruikelijker dan bedrijfstools die zijn gecontroleerd en goedgekeurd. Bedrijven moeten onmiddellijk stappen ondernemen om hun beleid te handhaven.

\ Met een beheerde omgeving kunnen organisaties het gebruik monitoren via tools, machtigingen instellen binnen databases en datagovernance afdwingen in alle afdelingen. Dit verbetert de productiviteit van werknemers en beschermt tegelijkertijd de data-integriteit en naleving van het bedrijf.

3. Monitor gegevensverplaatsing en modelgebruik

Zichtbaarheidstools die abnormaal gedrag markeren — zoals plotselinge toenames in AI-gebruik, het uploaden van gegevens naar ongebruikelijke eindpunten, of het benaderen van het model in een kort tijdsbestek met gevoelige gegevens — kunnen beveiligingsteams helpen misbruik en gegevenslekken te identificeren. Rapporten geven aan dat in het afgelopen jaar maar liefst 60% van de werknemers niet-goedgekeurde AI-tools gebruikte, en 93% gaf toe bedrijfsgegevens zonder toestemming in te voeren.

\ Het vroeg detecteren van deze patronen kan herstel, heropvoeding, herconfiguratie van machtigingen of beëindiging van het proces mogelijk maken voordat het leidt tot gegevenslekken of nalevingsinbreuken.

4. Train werknemers op AI-specifieke risico's

Cyberbeveiligingstraining in het algemeen is niet genoeg. AI kan hallucineren door de intentie achter prompts verkeerd te interpreteren en schijnbaar gezaghebbende, valse of bevooroordeelde inhoud te genereren. Bovendien moeten werknemers begrijpen dat het gebruik van AI verschilt van het gebruik van software of diensten. Veilig gebruik vereist het veranderen van mentale modellen, het begrijpen van promptrisico's en het omgaan met persoonlijke gegevens.

\ Gebruikers met basale machinegeletterdheid zullen output controleren op feiten en zijn minder geneigd om persoonlijke gegevens overmatig te delen. Ze zullen de tools behandelen als waardevolle co-piloten, maar ze moeten worden gebruikt onder menselijk toezicht.

Organisaties beschermen tegen Shadow AI

Shadow AI groeit sneller en is moeilijker te identificeren dan shadow IT. Hoewel de schaal en complexiteit van de risico's verschillen, kan het inschakelen van hulp van werknemers beide effectiever identificeren. Governancebeleid kan bedrijven helpen de juiste balans te vinden. Beveiligingsteams moeten hun blootstelling opnieuw beoordelen, waakzaam blijven voor opkomende bedreigingen en snel handelen voordat onzichtbare op AI gebaseerde tools cruciale beslissingen nemen in bedrijfstoepassingen.

Misschien vind je dit ook leuk

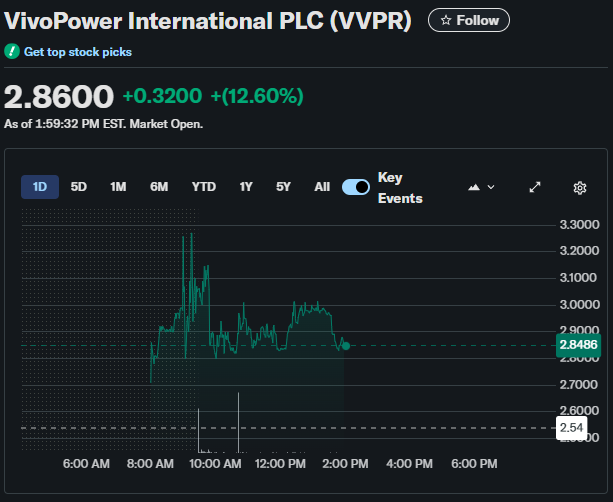

Investering van $300M van VivoPower in Ripple zorgt voor 13% stijging van aandelenkoers

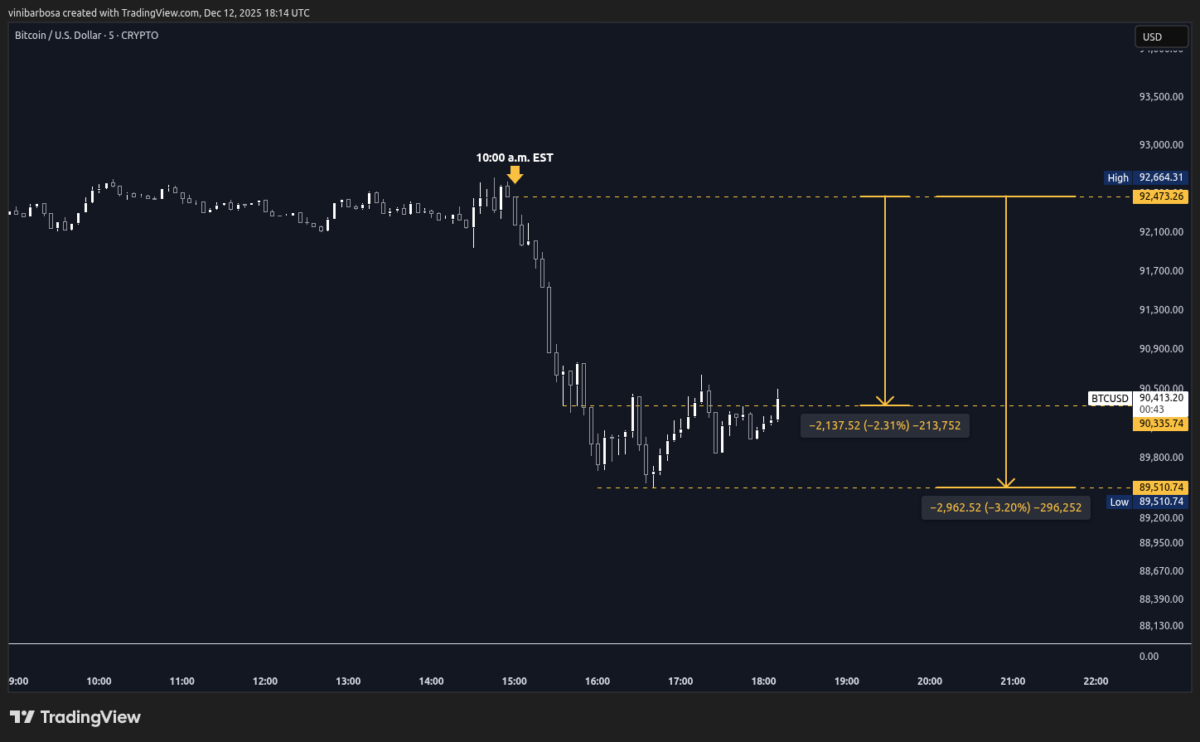

Manipulatie? Bitcoin Daalt $2.000 in 35 Minuten, $132M Longs Geliquideerd