Métodos de Investigação UX em Evolução para Agentes de IA na Colaboração Empresarial

\ A mudança aconteceu mais rápido do que qualquer um previu. Um dia, a IA estava a completar automaticamente as nossas frases. No dia seguinte, estava a participar nas nossas reuniões, a resumir as nossas conversas e a redigir mensagens de acompanhamento em nosso nome. Agora está a tomar decisões.

Passei anos a investigar como as equipas colaboram através de plataformas inteligentes, e o que estou a testemunhar hoje representa a transformação mais significativa na dinâmica do local de trabalho desde a introdução do email. Os Agentes de IA já não são ferramentas que usamos. São participantes com quem trabalhamos lado a lado.

Esta distinção é extremamente importante para os investigadores de experiência do usuário. Os métodos que desenvolvemos para avaliar funcionalidades de software simplesmente não se aplicam quando esse software começa a comportar-se como um membro da equipa.

A Mudança Fundamental: De Funcionalidade para Participante

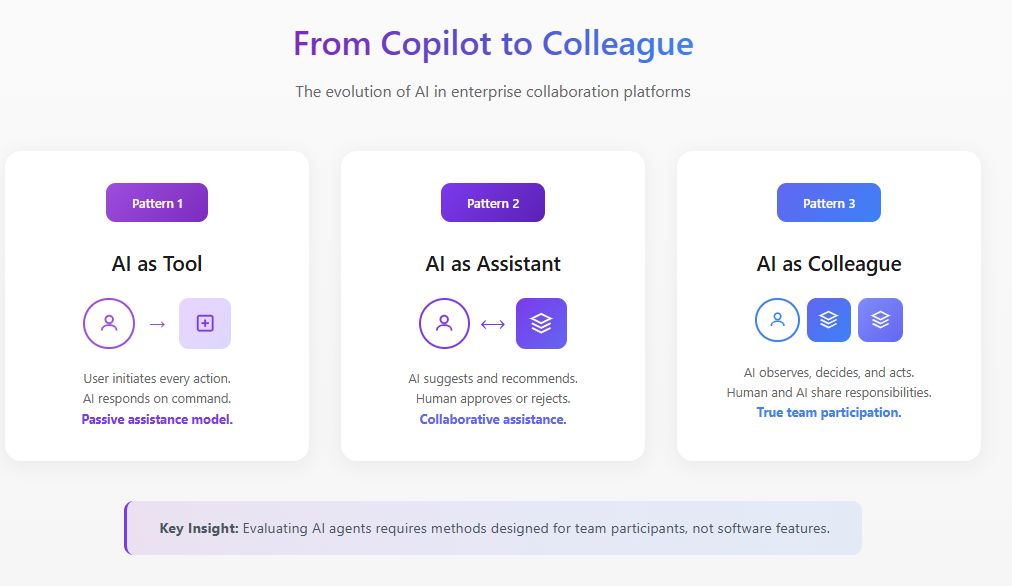

A investigação tradicional de experiência do usuário faz perguntas como: Esta funcionalidade é descobrível? A interação é intuitiva? Reduz o atrito no fluxo de trabalho?

Estas perguntas assumem que a IA é passiva, aguardando a entrada do usuário antes de responder. Mas os Agentes de IA operam de forma diferente. Eles observam, interpretam, decidem e agem. De acordo com a investigação de 2025 do MIT Sloan Management Review e do Boston Consulting Group, 35% das organizações já começaram a usar IA agêntica, com outros 44% a planear adotá-la em breve. No entanto, 47% indicam que não têm estratégia para o que vão fazer com a IA. Esta lacuna entre adoção e compreensão é precisamente onde a investigação de experiência do usuário deve intervir.

Quando um Agente de IA se junta a uma plataforma de colaboração, altera a dinâmica social da equipa. Afeta quem fala, quando fala e o que se sente confortável a dizer. Avaliar estas mudanças requer métodos que vão muito além dos testes de usabilidade.

\

Liderando a Avaliação de IA para Plataformas de Colaboração Empresarial

No meu trabalho liderando investigação de experiência do usuário para plataformas de colaboração inteligentes, desenvolvi estruturas de avaliação especificamente projetadas para Agentes de IA a operar em ambientes empresariais. Este trabalho situa-se na interseção da estratégia de produto, desenvolvimento de IA e investigação de fatores humanos.

A avaliação de IA neste contexto é fundamentalmente diferente do benchmarking tradicional de modelos. Quando um Agente de IA opera dentro de uma plataforma de colaboração, não podemos simplesmente medir a precisão ou a qualidade da resposta isoladamente. Devemos avaliar como o agente se comporta dentro da complexa dinâmica social e operacional de equipas reais.

Abordo as avaliações de IA para colaboração empresarial através de três camadas interconectadas. A primeira camada examina o desempenho funcional: o agente identifica corretamente itens de ação, resume discussões com precisão e apresenta informações relevantes em momentos apropriados? A segunda camada avalia a qualidade da integração: quão perfeitamente o agente opera dentro dos fluxos de trabalho existentes sem criar atrito ou exigir mudanças comportamentais dos usuários? A terceira camada, e a mais frequentemente negligenciada, avalia o impacto sistémico: como a presença do agente afeta a dinâmica da equipa, a qualidade da decisão e a eficácia colaborativa ao longo do tempo?

A investigação da Harvard Business Review de maio de 2025 descreve os Agentes de IA como "colegas de equipa digitais" representando uma categoria emergente de talento. Esta estruturação exige que avaliemos os Agentes de IA não apenas na conclusão de tarefas, mas em quão bem funcionam como participantes da equipa. Os meus protocolos de avaliação incorporam observação comportamental, acompanhamento longitudinal e análise de resultados que os benchmarks tradicionais de IA perdem completamente.

As organizações que alcançam os resultados mais fortes são aquelas que incorporam a investigação de experiência do usuário diretamente nos seus ciclos de avaliação de IA, usando métricas centradas no humano juntamente com medidas de desempenho técnico.

\

Construindo Agentes de IA Hiperpersonalizados Através de Investigação Estratégica de Experiência do Usuário

A próxima fronteira para plataformas de colaboração empresarial são Agentes de IA hiperpersonalizados que se adaptam a usuários individuais, culturas de equipa e contextos organizacionais. É aqui que a investigação de experiência do usuário se torna não apenas avaliativa, mas generativa, moldando diretamente como esses agentes são projetados e implementados.

Tenho liderado iniciativas de investigação que informam o desenvolvimento estratégico de Agentes de IA personalizados para plataformas de colaboração. Este trabalho envolve compreender os padrões específicos de como diferentes tipos de usuários interagem com a IA, como os estilos de comunicação da equipa variam entre funções e geografias, e como a cultura organizacional influencia o que os usuários esperam da assistência de IA.

A investigação de novembro de 2025 da McKinsey sobre parcerias de IA observa que realizar o potencial da IA requer redesenhar fluxos de trabalho para que pessoas, agentes e robôs trabalhem juntos efetivamente. De uma perspetiva de estratégia de produto, isso significa que os Agentes de IA não podem ser de tamanho único. Eles devem adaptar seu estilo de comunicação, frequência de intervenção e nível de autonomia com base nas preferências do usuário e fatores contextuais.

A minha investigação identificou várias dimensões de personalização que mais importam em contextos de colaboração empresarial. A correspondência de estilo de comunicação garante que o agente espelhe como os usuários se expressam naturalmente, seja formal ou casual, detalhado ou conciso. A calibração do tempo de intervenção aprende quando os usuários individuais preferem assistência proativa versus quando querem trabalhar sem interrupções. O ajuste do limiar de confiança reconhece que diferentes usuários têm diferentes níveis de conforto com a autonomia da IA e calibra de acordo.

As implicações estratégicas são significativas. As equipas de produto que constroem Agentes de IA para plataformas de colaboração precisam de input contínuo de investigação de experiência do usuário para entender como as funcionalidades de personalização se comportam em diversas populações de usuários. Sem esta base de investigação, os esforços de personalização correm o risco de criar agentes que parecem intrusivos para alguns usuários enquanto parecem inúteis para outros.

Uma Estrutura para Avaliar Agentes de IA em Ambientes Colaborativos

Através de extensa investigação de campo com equipas multifuncionais adotando Agentes de IA nos seus fluxos de trabalho colaborativos, desenvolvi uma estrutura de avaliação construída em torno de quatro dimensões que os métodos tradicionais negligenciam.

- Impacto da Presença examina como a presença do Agente de IA muda o comportamento da equipa, independentemente das suas contribuições funcionais. Observei equipas tornarem-se mensuravelmente mais formais quando sabem que uma IA está a documentar as suas conversas. Discussões laterais diminuem. O pensamento exploratório é substituído por contribuições mais seguras.

- Limites de Agência aborda onde a autonomia do Agente de IA deve começar e terminar, e como as equipas negociam esses limites. A orientação do Fórum Económico Mundial de 2025 sobre Agentes de IA enfatiza que a governança deve promover a transparência através do monitoramento contínuo. Na minha investigação, descobri que as preferências declaradas para a autonomia da IA raramente correspondem às preferências reveladas. As equipas frequentemente dizem que querem que os Agentes de IA tomem mais iniciativa, mas resistem quando os agentes realmente o fazem.

- Calibração de Confiança concentra-se em como as equipas desenvolvem confiança apropriada, evitando tanto a dependência excessiva quanto a subutilização. Um Agente de IA que comete um erro significativo pode destruir meses de construção de confiança, enquanto um agente que funciona perfeitamente pode criar uma complacência perigosa.

- Integração Colaborativa examina como o Agente de IA afeta a dinâmica da equipa, o fluxo de informações e a inteligência coletiva. O Agente de IA ajuda a equipa a tomar melhores decisões, ou cria uma ilusão de profundidade mascarando um pensamento superficial?

Estudo de Caso: Reconfigurando o Escopo do Agente de IA

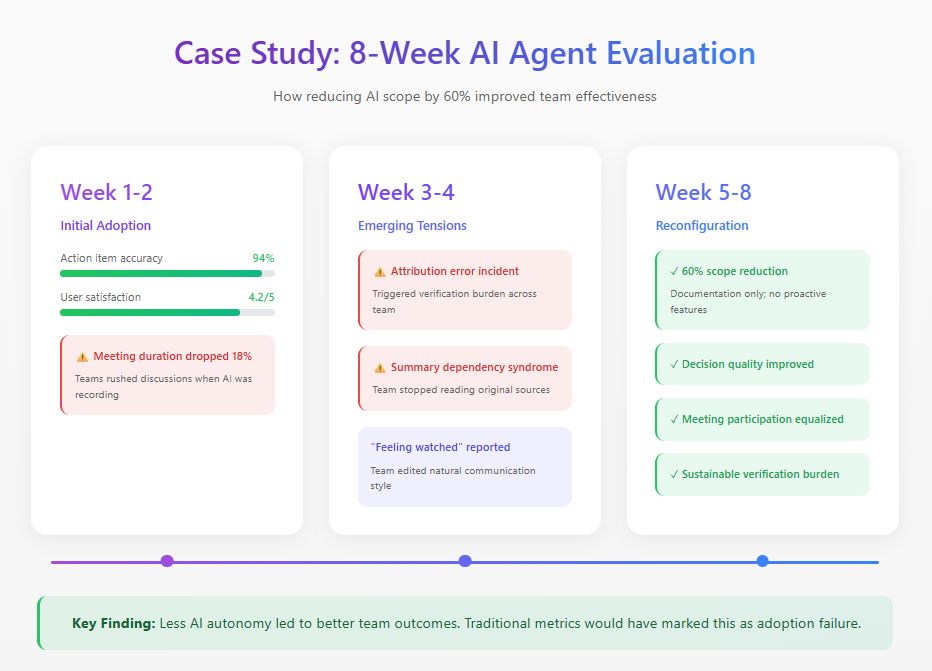

Recentemente conduzi um estudo de oito semanas com uma equipa de produto distribuída implementando um Agente de IA em toda a sua plataforma de colaboração. O agente foi projetado para participar em reuniões, gerar resumos, acompanhar decisões e proativamente apresentar informações relevantes.

As métricas iniciais pareciam excelentes: 94% de precisão nos itens de ação, 4,2 de 5 nas classificações de satisfação. Mas a observação comportamental revelou problemas invisíveis aos painéis. A duração das reuniões caiu 18% à medida que os membros da equipa apressavam as discussões, conscientes de que cada palavra estava sendo capturada. Na terceira semana, um erro de atribuição desencadeou uma carga de verificação que consumiu mais tempo do que a documentação que substituiu. Os membros da equipa também desenvolveram o que chamo de "síndrome de dependência de resumo", confiando exclusivamente nos resumos de IA e perdendo contexto crucial.

Com base nessas descobertas, a equipa reconfigurou o Agente de IA, reduzindo seu escopo funcional em 60%. Eles removeram recursos proativos enquanto mantinham tarefas de documentação onde a precisão era alta. As métricas tradicionais de adoção marcariam isso como fracasso. Mas as medidas de eficácia da equipa contaram uma história diferente: a qualidade da decisão melhorou, a participação nas reuniões tornou-se mais equitativa, e a carga de verificação caiu para níveis sustentáveis.

A descoberta mais significativa surgiu das entrevistas. Vários membros da equipa descreveram sentir-se "observados" durante a fase de autonomia total. Este efeito inibidor na comunicação autêntica nunca apareceu em nenhuma métrica de painel.

\

\

Métodos Práticos de Avaliação

Com base nesta investigação e estudos semelhantes, recomendo os seguintes métodos para avaliar Agentes de IA em ambientes colaborativos.

- Observação Longitudinal requer períodos mínimos de observação de seis semanas com estabelecimento de linha de base antes da introdução do Agente de IA. Testes de usabilidade de sessão única revelam quase nada útil sobre a dinâmica colaborativa de IA.

- Análise de Padrões de Comunicação envolve o acompanhamento quantitativo de quem fala, com que frequência e em que contextos nas fases de pré-implantação, implantação inicial e implantação madura.

- Avaliação de Calibração de Confiança mede regularmente como a confiança dos membros da equipa nas capacidades de IA se compara ao desempenho real da IA.

- Auditorias de Qualidade de Decisão fornecem análise retrospectiva de decisões tomadas com o envolvimento do Agente de IA, acompanhando resultados e identificando onde a contribuição da IA ajudou ou atrapalhou.

O Caminho a Seguir

Os Agentes de IA tornar-se-ão ubíquos na colaboração empresarial. A questão de investigação não é se as organizações os adotarão, mas como os integrarão efetivamente.

Os investigadores de experiência do usuário têm um papel crítico na formação desta integração. Possuímos os métodos para entender o comportamento humano e as estruturas para avaliar a qualidade da experiência. As organizações que acertarem nisso construirão sistemas de colaboração onde humanos e Agentes de IA genuinamente se complementam. Aqueles que tratam os Agentes de IA como apenas mais uma funcionalidade descobrirão que suas equipas trabalham menos efetivamente do que antes da chegada da tecnologia.

\

Você também pode gostar

Ouça o apelo de um filho, diz Jair Renan ao postar vídeo sobre Bolsonaro

Médico diz que Bolsonaro tem risco de estrangulamento intestinal