LLM — не тупик. Проблема AGI совсем в другом

Сегодня звучит много споров вокруг AGI: LLM якобы умеют только с некоторой вероятностью генерировать следующее слово в тексте, и потому на них "общий ИИ" не построишь. Авторы работы The Missing Layer of AGI: From Pattern Alchemy to Coordination Physics из Стэнфорда предлагают посмотреть на проблему иначе. Их идея в том, что LLM действительно не дают «готовый» общий интеллект, но причина не в том, что у них нет истинного понимания и мышления, а в том, что в них часто отсутствует отдельный модуь, который организует рассуждение как процесс: задаёт цель, подбирает инструменты, проверяет шаги, держит план и память.

Вместо привычной дилеммы «всё можно решить масштабированим» и «LLM — тупиковая ветвь развития» статья предлагает третью позицию: LLM — это мощный фундамент (то, что в когнитивной метафоре похоже на быстрый System‑1), а поверх него нужен System‑2 слой координации. И вот этот слой можно описывать, измерять и инженерно собирать.

Океан паттернов

Авторы предлагают метафору рыбалки. В LLM есть «океан» — огромное хранилище паттернов, ассоциаций и статистических привычек, накопленных на данных. Если задать вопрос без достаточной опоры, модель делает то, что от неё и ожидалось при обучении "прогнозирования следующего слова" (next-token prediction): подход выдаёт наиболее правдоподобный по прошлому опыту ответ.

Настоящее рассуждение появляется тогда, когда система умеет целенаправленно «приманивать» нужные структуры и одновременно фильтровать лишнее. То есть не просто генерировать, а управлять генерацией: закреплять смысл внешними ограничениями, проверять устойчивость и не терять нить в длинных задачах.

Как учёные предлагают это формализовать

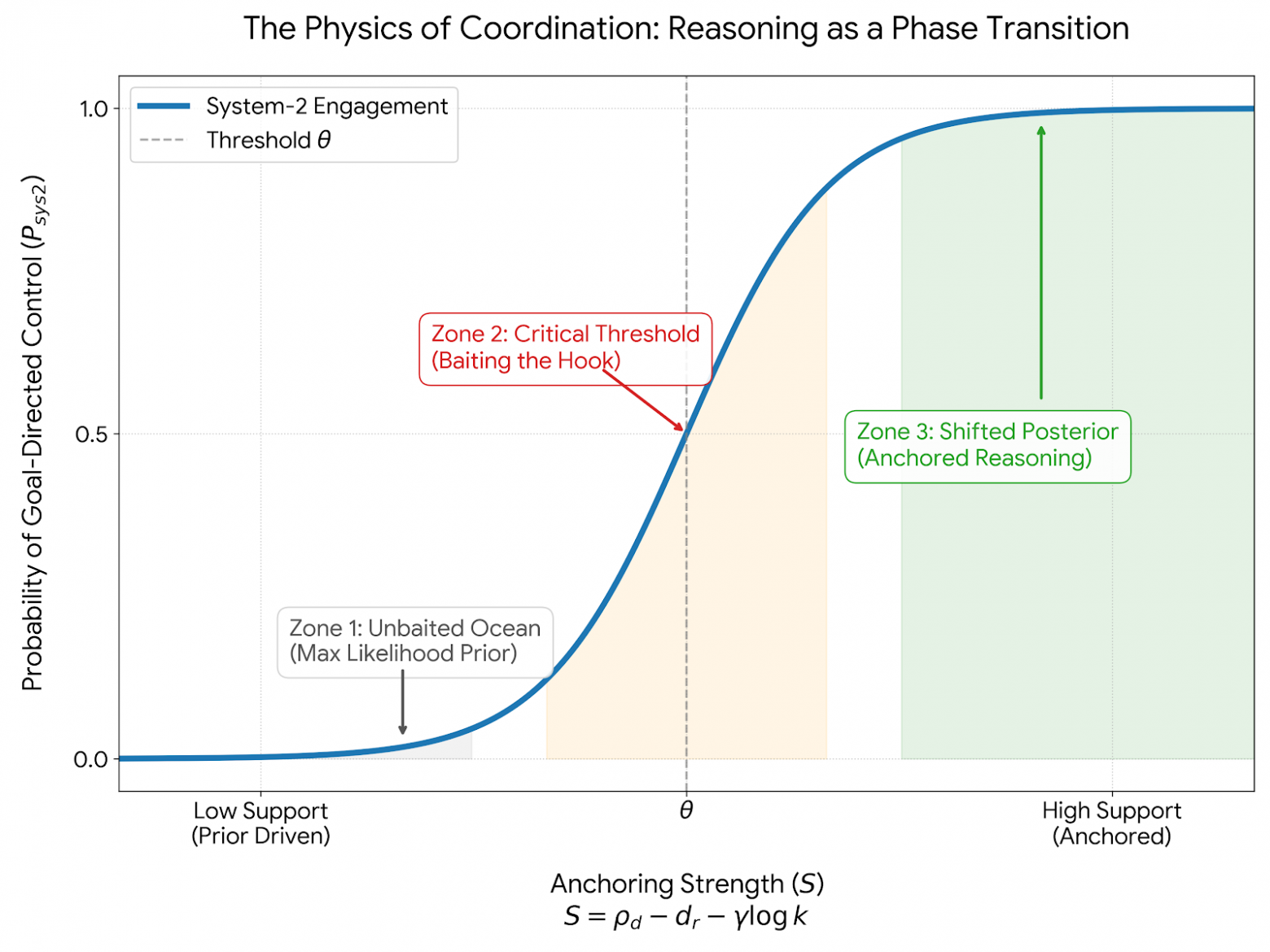

Ключевая идея статьи — семантическое якорение. Это любые внешние опоры, которые связывают вывод модели с задачей и ограничениями: примеры, retrieval, результаты инструментов, уточнения цели, проверяемые факты. Авторы утверждают, что эффект якорей часто нелинеен: чуть-чуть контекста может ничего не изменить, но при достижении определённого порога поведение системы резко переключается в более целевой режим.

Для описания они вводят показатель силы якорения S, который зависит от трёх вещей: насколько якоря действительно поддерживают нужную концепцию (ρ_d), насколько нестабильно представление и легко ли оно «съезжает» при переформулировках (d_r), и сколько якорей мы тащим в контекст (k), причём за избыточный контекст вводится штраф (γ log k). Важно, что якорение стоит ресурсов, и давать больше текста в промте не обязано поможет.

От теории к архитектуре

Чтобы это не осталось философией, авторы переводят идею в набросок архитектуры MACI (Multi-Agent Collaborative Intelligence). Смысл в том, что модуль координации удобнее строить не как одну монолитную LLM, а как систему ролей: кто-то генерирует гипотезы, кто-то спорит и расширяет поиск, кто-то судит по сократическим правилам, отбрасывая плохо поставленные аргументы, а память фиксирует обязательства и промежуточные результаты так, чтобы система могла откатываться и чинить локальные ошибки, а не переписывать всё заново.

Здесь исследование звучит особенно практично: многие типичные провалы LLM — это про отсутствие инженерной дисциплины вокруг рассуждения. Не хватает проверок, управления разногласиями, устойчивой памяти, инструментальных верификаторов, правил остановки. Авторы предлагают смотреть на это как на диагностируемые сбои координации: можно ли поднять ρ_d, снизить d_r, разумно потратить бюджет k и перевести систему через порог?

Почему «кот» проще «якорится», чем «панголин»

Интересная деталь: сложность якорения не одинакова для всех понятий. Если объект близок к распространённым прототипам, система легче стабилизирует представление (условно ниже d_r). Если объект редкий, необычный, плохо связан с привычными шаблонами, нужны либо более сильные якоря, либо «мостики» — промежуточные описания и аналогии, которые связывают новое с уже освоенным.

Что в итоге меняется в разговоре про AGI

Главный вывод статьи спокойный и, пожалуй, полезный для отрасли: LLM — не тупик для AGI. Они — сильная база, но без слоя координации мы постоянно будем сталкиваться с тем, что система то удивительно умна, то внезапно не может решить простые задачи. Авторы предлагают рассматривать такие «переключения» как управляемую область исследований: строить измеримые механизмы якорения, обучать политики управления обсуждением в мультиагентной системе, проектировать память для рассуждения, добавлять grounding через мультимодальность и инструменты, а символические компоненты использовать скорее как проверяющие контуры, чем как замену LLM.

Это не готовый рецепт AGI, но это понятный фреймворк: что мы упускаем и какие рычаги можно крутить, чтобы из предсказания следующего слова можно было получить надёжную, проверяемую работу системы в длинных задачах.

Моё мнение таково: LLM — это только текстовая модальность. Проблема AGI заключается не в самом тексте, а в способности системы подбирать следующий токен как универсальное действие для решения задач — в том числе через мультиагентное взаимодействие. Ключевым становится умение действовать мультимодально: работать с аудио, видео, телесными сигналами, 3D-средами. Все эти формы восприятия и действия — такие же латентные пространства, как и текст, просто с иной геометрией и динамикой. AGI начинается там, где возникает единое пространство смыслов, позволяющее переходить между модальностями и выбирать действие. Поэтому LLM — необходимая база на пути к настоящим моделям мира.

И в этом смысле Людвиг Витгенштейн справедливо сказал:

«Границы моего языка означают границы моего мира».

📜 Полная статья

***

Если вам интересна тема ИИ, подписывайтесь на мой Telegram-канал — там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Источник

Вам также может быть интересно

Вокруг RecSys ML 1: универсальный план по MLSD и основные проблемы RecSys

Zedcex разоблачен как крупная криптовалютная платформа, поддерживающая переводы средств КСИР