本文提出了一种新颖的决策边界感知蒸馏方法,用于实例增量学习,无需访问旧数据。本文提出了一种新颖的决策边界感知蒸馏方法,用于实例增量学习,无需访问旧数据。

医学图像合成:用于RUSS和分割的S-CycleGAN

链接表

摘要和1 引言

-

相关工作

-

问题设定

-

方法论

4.1. 决策边界感知蒸馏

4.2. 知识巩固

-

实验结果和5.1. 实验设置

5.2. 与最先进方法的比较

5.3. 消融研究

-

结论和未来工作及参考文献

\

补充材料

- IIL中KCEMA机制理论分析的详细信息

- 算法概述

- 数据集详情

- 实现细节

- 灰尘输入图像的可视化

- 更多实验结果

4. 方法论

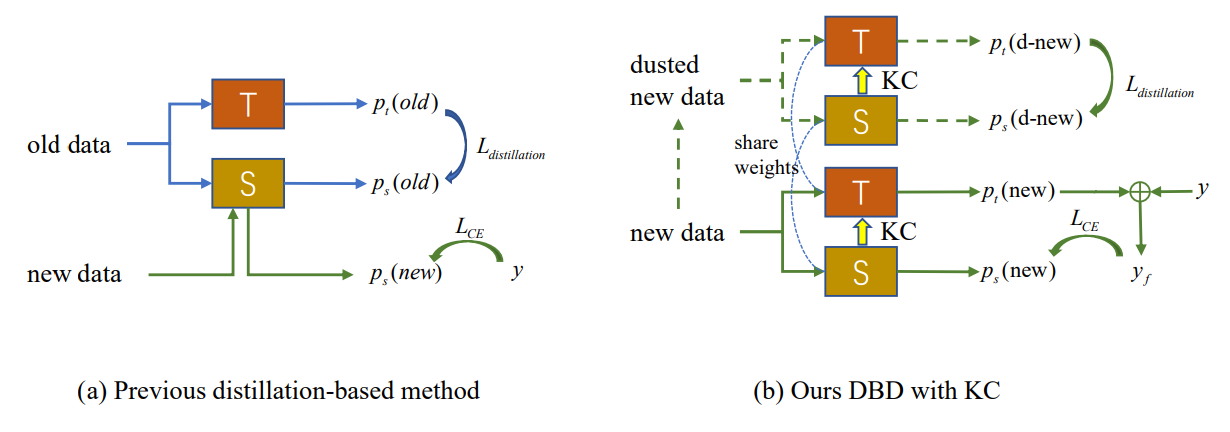

如图2(a)所示,新观察中概念漂移的出现导致现有模型失效的外部样本的出现。新的IIL必须扩大决策边界以包含这些外部样本,同时避免在旧边界上发生灾难性遗忘(CF)。传统的基于知识蒸馏的方法依赖于一些保留的样例[22]或辅助数据[33, 34]来抵抗CF。然而,在所提出的IIL设置中,除了新的观察外,我们无法访问任何旧数据。如果不向模型添加新参数,基于这些新观察的蒸馏与学习新知识相冲突。为了在学习和不遗忘之间取得平衡,我们提出了一种不需要旧数据的决策边界感知蒸馏方法。在学习过程中,学生学到的新知识会间歇性地巩固回教师模型,这带来了更好的泛化能力,是该领域的先驱尝试。

\

\

:::info 作者:

(1) 聂强,香港科技大学(广州);

(2) 付伟福,腾讯优图实验室;

(3) 林宇欢,腾讯优图实验室;

(4) 李佳林,腾讯优图实验室;

(5) 周一峰,腾讯优图实验室;

(6) 刘勇,腾讯优图实验室;

(7) 聂强,香港科技大学(广州);

(8) 王成杰,腾讯优图实验室。

:::

:::info 本论文可在arxiv上获取,遵循CC BY-NC-ND 4.0 Deed(署名-非商业性使用-禁止演绎4.0国际)许可协议。

:::

\

免责声明: 本网站转载的文章均来源于公开平台,仅供参考。这些文章不代表 MEXC 的观点或意见。所有版权归原作者所有。如果您认为任何转载文章侵犯了第三方权利,请联系 service@support.mexc.com 以便将其删除。MEXC 不对转载文章的及时性、准确性或完整性作出任何陈述或保证,并且不对基于此类内容所采取的任何行动或决定承担责任。转载材料仅供参考,不构成任何商业、金融、法律和/或税务决策的建议、认可或依据。

您可能也会喜欢

今日加密货币涨幅榜:M、XMR、PAXG、XAUt和TRX在美联储降息引发市场崩盘时领涨

数据指出了今天涨幅最高的加密资产;然而,由于今天目睹的市场崩盘,大多数加密货币几乎没有录得任何涨幅。

分享

Blockchainreporter2025/12/11 23:50

2026年加密货币投资转变:为何投资者从云挖矿转向如Poain等平台?

在2025年,加密货币市场出人意料地复苏,这被投资者所观察到。比特币在第二次减半后获得了提振,以太坊保持在

分享

Crypto Ninjas2025/12/12 00:19

Ondo、State Street、Galaxy Digital将于2026年推出SWEEP流动性基金

Ondo Finance 正在与 State Street Investment Management 和 Galaxy Asset Management 合作推出 SWEEP。文章 Ondo, State Street, Galaxy Digital

分享

Coinspeaker2025/12/12 00:28