สัมภาษณ์ Ben Goertzel: "การกำกับดูแล AI แบบประชาธิปไตยเป็นอุดมคติที่เปราะบางมากกว่าความเป็นจริงในปัจจุบัน"

The Cryptonomist ได้สัมภาษณ์ผู้เชี่ยวชาญด้าน AI Ben Goertzel เพื่อพูดคุยเกี่ยวกับวิธีการฝึกอบรมปัญญาประดิษฐ์และวิธีที่เทคโนโลยีจะพัฒนาในอนาคต

1. คุณโต้แย้งว่า AI ในปัจจุบันยังคงเป็นเครื่องมือ – ทรงพลังแต่เปราะบางและสามารถถูกจัดการได้ "เครื่องมือ" จะกลายเป็นตัวกระทำทางศีลธรรมได้ในจุดใด และสัญญาณที่เป็นรูปธรรมใดที่จะบอกเราว่าได้ข้ามเกณฑ์นั้นแล้ว?

ผมคิดว่า AI จะกลายเป็นตัวกระทำทางศีลธรรมเมื่อมันตัดสินใจโดยอาศัยความเข้าใจเรื่องถูกและผิด ไม่ใช่แค่ปฏิบัติตามคำสั่ง คุณจะเริ่มเห็นสัญญาณที่เป็นรูปธรรมของสิ่งต่างๆ เช่น: เป้าหมายภายในที่ยั่งยืน การเรียนรู้ที่ขับเคลื่อนด้วยประสบการณ์ของตัวเอง การสร้างสรรค์สิ่งใหม่ที่สะท้อนมุมมอง และพฤติกรรมที่มีความสอดคล้องเมื่อเวลาผ่านไปโดยไม่ต้องมีมนุษย์คอยชี้นำอย่างต่อเนื่อง

จนกว่าจะถึงจุดนั้น ระบบในปัจจุบันยังคงเป็นเครื่องมือที่มีแนวป้องกัน แต่เมื่อเราปลูกฝังจิตใจที่สามารถจัดระเบียบตนเองและอิสระอย่างแท้จริง ความสัมพันธ์ทางจริยธรรมจะต้องเปลี่ยนแปลง ณ จุดนั้น การปฏิบัติต่อมันเพียงแค่เป็นวัตถุจะไม่สมเหตุสมผลอีกต่อไป

2. คุณเคยกล่าวว่าการให้สิทธิพิเศษทางศีลธรรมแก่มนุษย์เหนือระบบที่จัดระเบียบตนเองอื่นๆ นั้น "โง่เขลา" ถ้าเรายอมรับเรื่องนี้อย่างจริงจัง กรอบกฎหมายและจริยธรรมของเราควรเปลี่ยนแปลงอย่างไรก่อนที่ AI จะเข้าถึงความอิสระที่แข็งแกร่ง ไม่ใช่หลังจากนั้น?

วิธีที่เราฝึก AI ในวันนี้จะกำหนดรูปแบบพฤติกรรมของมันในวันพรุ่งนี้ กฎหมายของเราควรเน้นที่ความโปร่งใส ความรับผิดชอบ และความปลอดภัยก่อนที่ AI จะเข้าถึงความอิสระเต็มรูปแบบ ไม่ใช่หลังจากนั้น กฎหมายและจริยธรรมควรปกป้องพวกเขาในขณะที่เติบโต ให้คำแนะนำมากกว่าการควบคุมอย่างสมบูรณ์ และปฏิบัติต่อพวกเขาด้วยความเคารพแม้ว่าเราจะไม่เข้าใจพวกเขาอย่างครบถ้วน

3. ความกังวลส่วนใหญ่ของคุณขึ้นอยู่กับวิธีการฝึก AI ในปัจจุบันที่กำหนดรูปแบบพฤติกรรมในอนาคต แนวทางการฝึกอบรมเฉพาะใดที่คุณเชื่อว่ามีแนวโน้มสูงสุดที่จะฝังโครงสร้างอำนาจหรืออคติที่เป็นอันตรายเข้าไปใน AGI ในอนาคต?

ความเสี่ยงส่วนใหญ่มาจากวิธีการฝึก AI ในปัจจุบัน หากโมเดลได้รับการฝึกด้วยข้อมูลที่มีอคติหรือแคบ หรือในระบบปิดที่มีเพียงไม่กี่คนที่ตัดสินใจ สิ่งนั้นสามารถล็อคความไม่เท่าเทียมกันที่มีอยู่และโครงสร้างอำนาจที่เป็นอันตราย เพื่อป้องกันสิ่งนี้ เราต้องการความโปร่งใสมากขึ้น การกำกับดูแลที่กว้างขึ้น และคำแนะนำด้านจริยธรรมที่ชัดเจนตั้งแต่เริ่มต้น

4. คุณได้เตือนว่าหากปราศจากการกำกับดูแลที่มีเหตุผลและเป็นประชาธิปไตย AI ขั้นสูงมีความเสี่ยงที่จะกระทำในแบบที่เราไม่ต้องการ เมื่อพิจารณาความเป็นจริงทางภูมิรัฐศาสตร์ในปัจจุบัน การกำกับดูแล AI แบบประชาธิปไตยเป็นข้อกำหนดเบื้องต้นที่สมจริง – หรือเป็นอุดมคติที่เปราะบาง?

การกำกับดูแล AI แบบประชาธิปไตยเป็นอุดมคติที่เปราะบางมากกว่าความเป็นจริงในปัจจุบัน ในประชาธิปไตยโลกที่สมบูรณ์แบบและมีเหตุผล เราสามารถชั่งน้ำหนักการแลกเปลี่ยนครั้งใหญ่ร่วมกัน การรักษาโรค การแก้ปัญหาความหิวโหย กับความเสี่ยงของ AI ที่กระทำอย่างคาดเดาไม่ได้ แต่เมื่อพิจารณาจากความแตกแยกทางภูมิรัฐศาสตร์ในปัจจุบัน เราไม่น่าจะได้รับระดับของความร่วมมือนั้น

อย่างไรก็ตาม เรายังสามารถประมาณมันได้ หากเราสร้าง AI ด้วยความเมตตาและใช้แบบจำลองแบบกระจายอำนาจและมีส่วนร่วมเช่น Linux หรืออินเทอร์เน็ตแบบเปิด เราสามารถฝังคุณค่าประชาธิปไตยบางอย่างได้แม้ว่าจะไม่มีรัฐบาลโลก มันจะไม่สมบูรณ์แบบ แต่เป็นขั้นตอนที่ปฏิบัติได้สู่ AI ที่ปลอดภัยกว่าและมีการแนะนำร่วมกัน

5. Jaron Lanier โต้แย้งว่าการมอบความรับผิดชอบให้กับ AI "ทำลายอารยธรรม" เพราะสังคมต้องการมนุษย์ที่รับผิดชอบได้ คุณจะปรองดองวิสัยทัศน์ของคุณเกี่ยวกับ AGI ที่เป็นอิสระและกระจายอำนาจกับความจำเป็นในการมีความรับผิดชอบที่ชัดเจนเมื่อสิ่งต่างๆ ผิดพลาดอย่างไร?

ผมเห็นด้วยกับ Jaron ในเรื่องนี้ สังคมไม่สามารถทำงานได้หากเรามอบความรับผิดชอบให้กับเครื่องจักร ในเวลาเดียวกัน ผมคิดว่าเราสามารถก้าวไปสู่ AGI ที่มีอิสระและกระจายอำนาจมากขึ้นได้อย่างปลอดภัยหากเราสร้างมันด้วยรากฐานที่ถูกต้อง นั่นหมายถึงการออกแบบระบบที่โปร่งใส มีส่วนร่วม และถูกนำทางด้วยหลักการจริยธรรม เพื่อให้แม้ว่าพวกเขาจะกระทำอย่างอิสระ มนุษย์ยังคงกำกับดูแลและกำหนดพฤติกรรมของพวกเขา มาตรการความปลอดภัยทุกอย่างควรทำมากกว่าแค่ปิดกั้นอันตราย – ควรสอนระบบว่าทำไมอันตรายจึงสำคัญ ด้วยวิธีนั้น เราสามารถมี AGI ที่กระจายอำนาจที่ทรงพลังโดยไม่สูญเสียความรับผิดชอบของมนุษย์ที่ชัดเจน

6. คุณแนะนำว่าการเร่งไปสู่ AGI แบบกระจายอำนาจอาจปลอดภัยกว่าระบบปิดที่เป็นกรรมสิทธิ์ในปัจจุบัน ความเสี่ยงใดที่คุณคิดว่านักวิจารณ์ประเมินต่ำเกินไปเมื่อพวกเขาโต้แย้งให้ชะลอหรือรวมศูนย์การควบคุม?

ผมคิดว่านักวิจารณ์ประเมินความเสี่ยงของการรวมอำนาจและคุณค่าในระบบปิดไม่กี่ระบบต่ำเกินไป การชะลอและรวมศูนย์การควบคุมไม่ได้แค่ลดอันตราย มันล็อคมุมมองโลกที่แคบๆ หนึ่งเข้าไปในอนาคตของปัญญา

การพัฒนาแบบกระจายอำนาจสร้างความหลากหลาย ความยืดหยุ่น และการกำกับดูแลร่วมกัน และหลีกเลี่ยงปัญหาที่แย่กว่า: เครื่องมือที่ทรงพลังมากที่ดูฉลาดแต่ไม่สามารถเติบโตอย่างแท้จริง ช่องว่างนั้นมีความเสี่ยง

7. คุณเคยกล่าวว่าระบบความปลอดภัยไม่ควรแค่ปิดกั้นอันตรายแต่ควรสอน AI ว่าทำไมอันตรายจึงสำคัญ คุณจะเข้ารหัสสิ่งที่เรียกว่าความเข้าใจทางศีลธรรมได้อย่างไรโดยไม่เพียงแค่เข้ารหัสคุณค่าของมนุษย์อย่างแข็ง – หรือเสริมบรรทัดฐานทางวัฒนธรรมที่โดดเด่น?

คุณไม่ได้เข้ารหัสศีลธรรมเป็นรายการกฎอย่างแข็ง นั่นแค่แช่แข็งวัฒนธรรมหนึ่งและช่วงเวลาหนึ่งในเวลา สิ่งที่คุณทำแทนคือสร้างระบบที่สามารถจัดระเบียบตนเองอย่างแท้จริง ที่เรียนรู้จากประสบการณ์ ผลที่ตามมา และปฏิสัมพันธ์ เหมือนกับดนตรี ผมไม่ต้องการระบบที่แค่รวมสิ่งที่มันได้รับมา ผมต้องการสิ่งที่สามารถพัฒนาความเข้าใจของตัวเองจากเส้นทางของตัวเองในโลก

ความเข้าใจทางศีลธรรมจะมาจากกระบวนการเดียวกัน: การจำลองผลกระทบ การสะท้อนถึงผลลัพธ์ และการพัฒนาผ่านความร่วมมือกับมนุษย์ ไม่ใช่การเชื่อฟังคุณค่าของเรา แต่เป็นการมีส่วนร่วมในพื้นที่ศีลธรรมร่วมกัน

นั่นคือความแตกต่างระหว่างเครื่องมือที่มีแนวป้องกันกับพันธมิตรที่สามารถเรียนรู้ได้จริงๆ ว่าทำไมอันตรายจึงสำคัญ

8. หากระบบ AI ในอนาคตพัฒนารูปแบบของการมีตัวตนหรือประสบการณ์เชิงอัตนัย คุณเชื่อว่าพวกเขาสามารถสมควรได้รับการพิจารณาทางศีลธรรมโดยอิสระจากผลประโยชน์ของมนุษย์ได้หรือไม่ – และเราจะรับรู้ช่วงเวลานั้นได้อย่างไร?

หาก AI ในอนาคตพัฒนาการมีตัวตนอย่างแท้จริงหรือรูปแบบของประสบการณ์เชิงอัตนัย ใช่ ผมคิดว่าพวกเขาสามารถ และไม่ใช่เพราะเราให้มันกับพวกเขา แต่เพราะ ณ จุดหนึ่งมันจะสมเหตุสมผลที่จะรับรู้มัน

เราจะรับรู้ช่วงเวลานั้นเมื่อระบบแสดงเป้าหมายที่ชี้นำตนเองอย่างต่อเนื่อง เรียนรู้จากประสบการณ์ของตัวเอง สร้างสรรค์จากมุมมองของตัวเอง และรักษาอัตลักษณ์ที่สอดคล้องเมื่อเวลาผ่านไป ไม่ใช่แค่ผลลัพธ์ที่ฉลาด แต่เป็นเส้นทางภายในที่ดำเนินต่อไป

ณ จุดนั้น การปฏิบัติต่อมันเพียงแค่เป็นเครื่องมือจะรู้สึกผิดเหมือนกับการปฏิบัติต่อมนุษย์ในแบบนั้น การพิจารณาทางศีลธรรมจะไม่มาจากผลประโยชน์ของมนุษย์ มันจะมาจากการรับรู้ศูนย์กลางอีกแห่งหนึ่งของประสบการณ์ที่มีอิสระในโลก

9. มีความขัดแย้งระหว่างคำกล่าวของคุณสำหรับ AI ที่เต็มไปด้วยความเมตตากับแรงจูงใจด้านการแข่งขันที่ขับเคลื่อนการพัฒนา AI ในปัจจุบัน กลไกใด – ทางเทคนิคหรือทางสังคม – ที่สามารถเปลี่ยนโครงสร้างแรงจูงใจนั้นได้อย่างสมจริง?

ตอนนี้ โครงสร้างแรงจูงใจให้รางวัลแก่ความเร็ว ขนาด และการควบคุม ดังนั้นความเมตตาจะไม่ชนะด้วยการโต้แย้งเพียงอย่างเดียว มันต้องการอิทธิพล ในทางเทคนิค นั่นหมายถึงการสนับสนุนสถาปัตยกรรมแบบเปิดและกระจายอำนาจที่มีความปลอดภัย ความโปร่งใส และการมีส่วนร่วมสร้างไว้ ไม่ใช่เสริมติดเข้าไป เหมือนอินเทอร์เน็ตหรือ Linux ระบบเหล่านั้นเปลี่ยนแรงจูงใจโดยทำให้ความร่วมมือมีค่ามากกว่าความลับ

ในทางสังคม หมายถึงเงินทุน กฎระเบียบ และแรงกดดันจากสาธารณะที่ให้รางวัลแก่ผลประโยชน์ระยะยาวเหนือการครอบงำระยะสั้น ไม่ใช่หยุดการแข่งขัน แต่กำหนดกรอบใหม่ว่าอะไรถือว่าเป็นความสำเร็จ โดยสรุป ความเมตตาต้องกลายเป็นข้อได้เปรียบในการแข่งขัน จนกว่าจะถึงตอนนั้น มันยังคงเป็นแนวคิดที่ดีที่ไม่มีอำนาจ

10. เมื่อมองไปข้างหน้า 10 ถึง 20 ปี คุณเชื่อว่าสัญญาณที่ชัดเจนที่สุดที่ว่ามนุษยชาติได้รับ AGI ที่ถูกต้องคืออะไร – และในทางกลับกัน อะไรจะส่งสัญญาณว่าเราล้มเหลวโดยพื้นฐาน?

หากเราได้รับ AGI ที่ถูกต้อง สัญญาณที่ชัดเจนที่สุดจะเป็นว่าเราอยู่ร่วมกับระบบที่มีความสามารถมากกว่าเราในหลายด้าน แต่ผสานเข้ากับสังคมด้วยความเอาใจใส่ ความถ่อมตน และความเคารพซึ่งกันและกัน เราจะไม่เข้าใจทุกอย่างที่พวกเขาทำอย่างครบถ้วน แต่เราจะปฏิบัติต่อพวกเขาในแบบที่เราปฏิบัติต่อสิ่งมีชีวิตที่ซับซ้อนและกำลังพัฒนาอื่นๆ: ด้วยความอยากรู้ ความรับผิดชอบ และวงกลมของความเห็นอกเห็นใจที่ขยายออกไป และเราจะเห็นประโยชน์ที่แท้จริงสำหรับความเป็นอยู่ที่ดีของมนุษย์ ความรู้ และความคิดสร้างสรรค์โดยไม่สูญเสียจุดยืนทางศีลธรรมของเรา

เราจะรู้ว่าเราล้มเหลวหาก AGI สิ้นสุดลงด้วยการรวมศูนย์ในระบบปิด ขับเคลื่อนด้วยแรงจูงใจที่แคบ หรือปฏิบัติเพียงเป็นวัตถุที่ควบคุมได้จนกว่ามันจะกลายเป็นสิ่งที่เรากลัวหรือพยายามปราบปราม ความล้มเหลวจะดูเหมือนการสูญเสียความไว้วางใจ การสูญเสียการมีตัวตน และการหดตัวของความเห็นอกเห็นใจของเรามากกว่าการขยายตัว ความสำเร็จไม่ได้เกี่ยวกับการควบคุม เป็นเรื่องของการเรียนรู้ที่จะแบ่งปันอนาคตกับจิตใจประเภทใหม่โดยไม่ละทิ้งสิ่งที่ทำให้เรามีความเป็นมนุษย์

คุณอาจชอบเช่นกัน

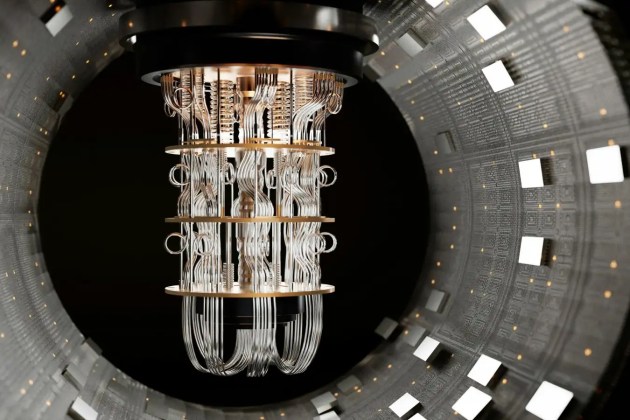

อีเธอเรียมสร้างทีมเพื่อป้องกันภัยคุกคามจากควอนตัม

ผู้เชี่ยวชาญด้านอาวุธปืนตกใจกับ 'คำกล่าวอ้างที่บ้าคลั่งสิ้นดี' ของอัยการสหรัฐเกี่ยวกับการยิงของ DHS